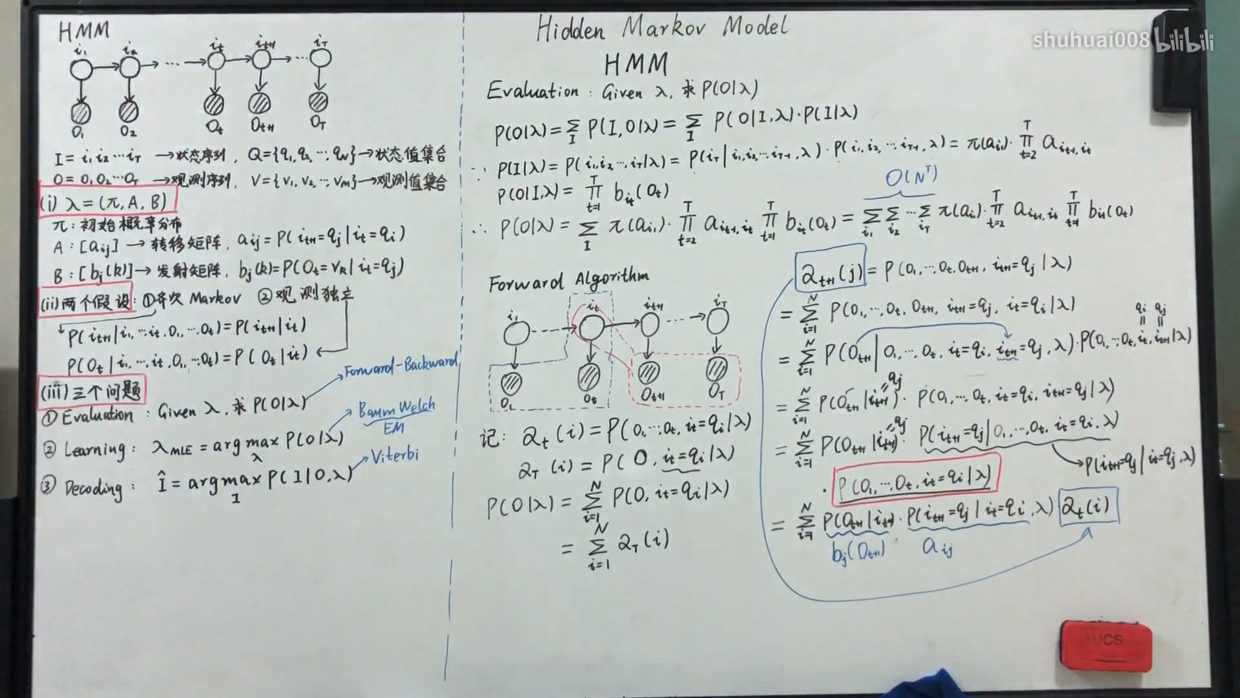

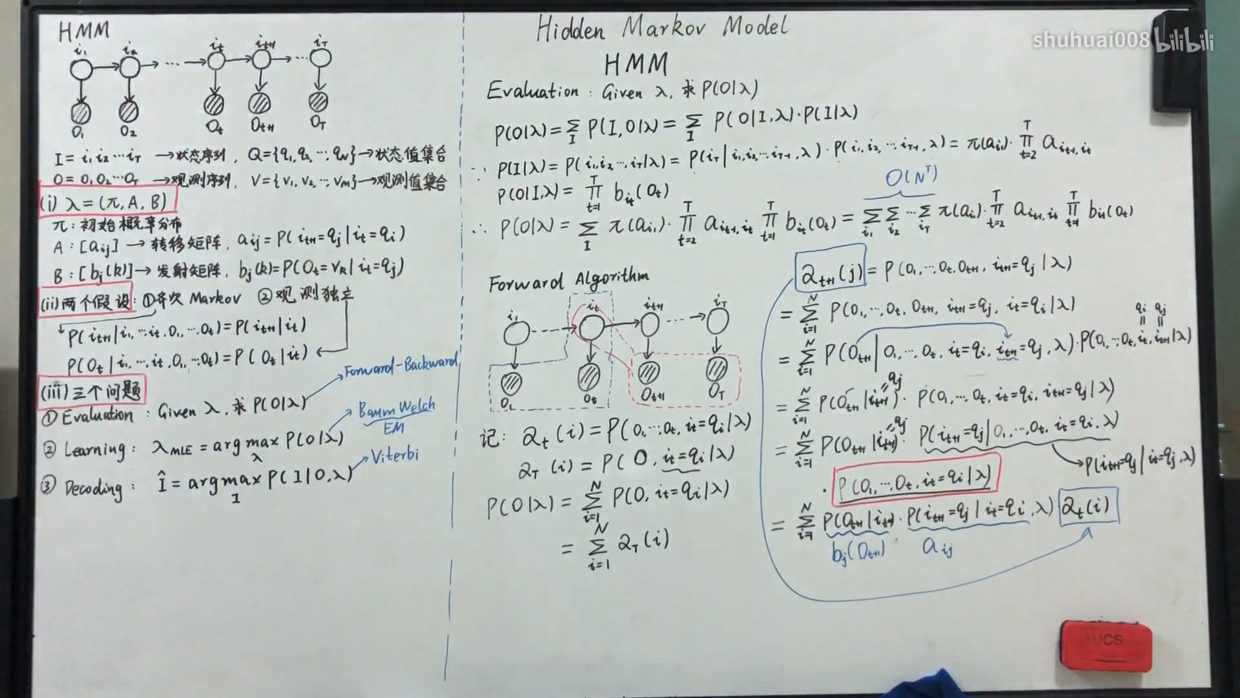

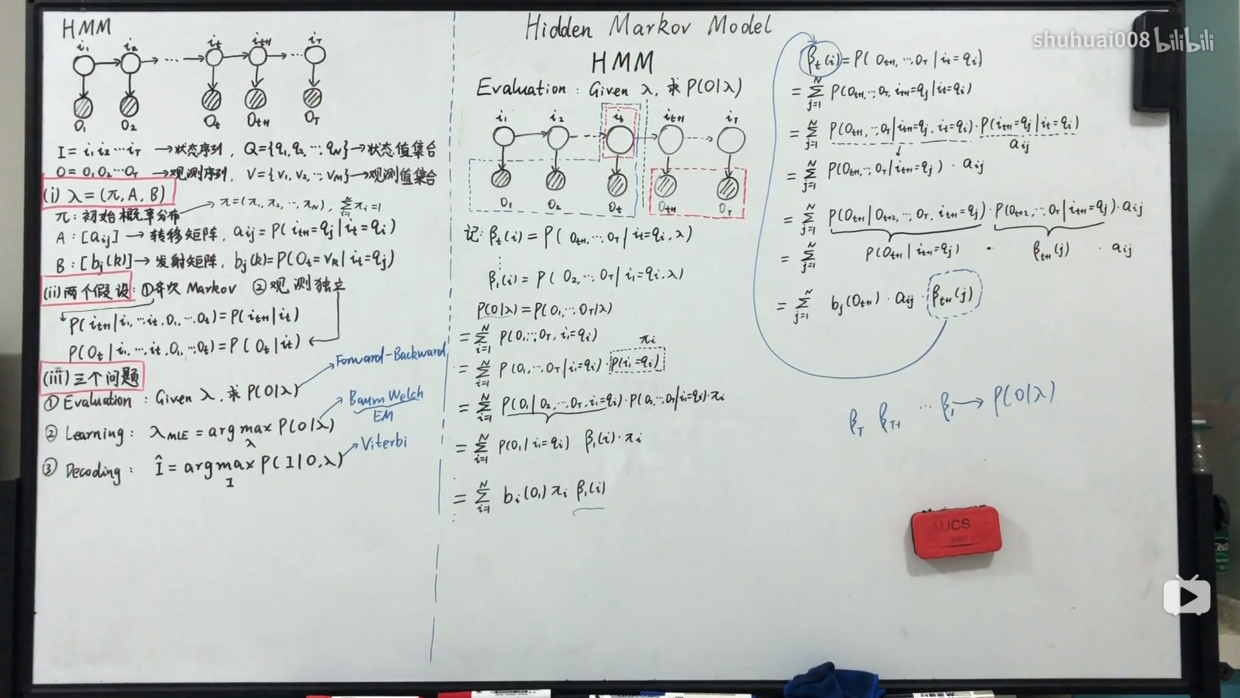

一个模型

HMM定义为λ=(N,M,π,A,B)

**N:**模型中马尔可夫链的状态数目[s1,s2,...,sN]。如果记t时刻Markov链所处的状态qt,那么qt∈(s1,s2,...,sN)。

**M:**每个状态可能输出的观测符号数目[θ1,θ2,...,θM]。如果记t时刻Markov链所处的观测值维Ot,那么Ot∈(θ1,θ2,...,θM)。

**π:**初始状态概率分布矢量,π=(π1,π2,...,πN)。某一时刻处于某一状态的概率。$\pi = P(q_t=s_i),1 \leq i \leq N $。

**A:**状态转移概率矩阵。A={aij}NN 。aij=P(qt+1=sj,qt=si);1≤i,j≤N表示两个状态之间的转移概率。

**B:**观测符号概率分布,B={bj(k)}NM。其中:bj(k)=P(Ot=Vk∣qi=sj)。对于连续HMM,B是一组观察值概率函数,即B={bj(X),j=1,2,...,N}。

两个假设:

齐次Markov假设:t+1时刻的隐藏状态只与t时刻的隐藏状态有关。

观察独立假设:t时刻的隐藏状态只与t时刻的观测变量有关。

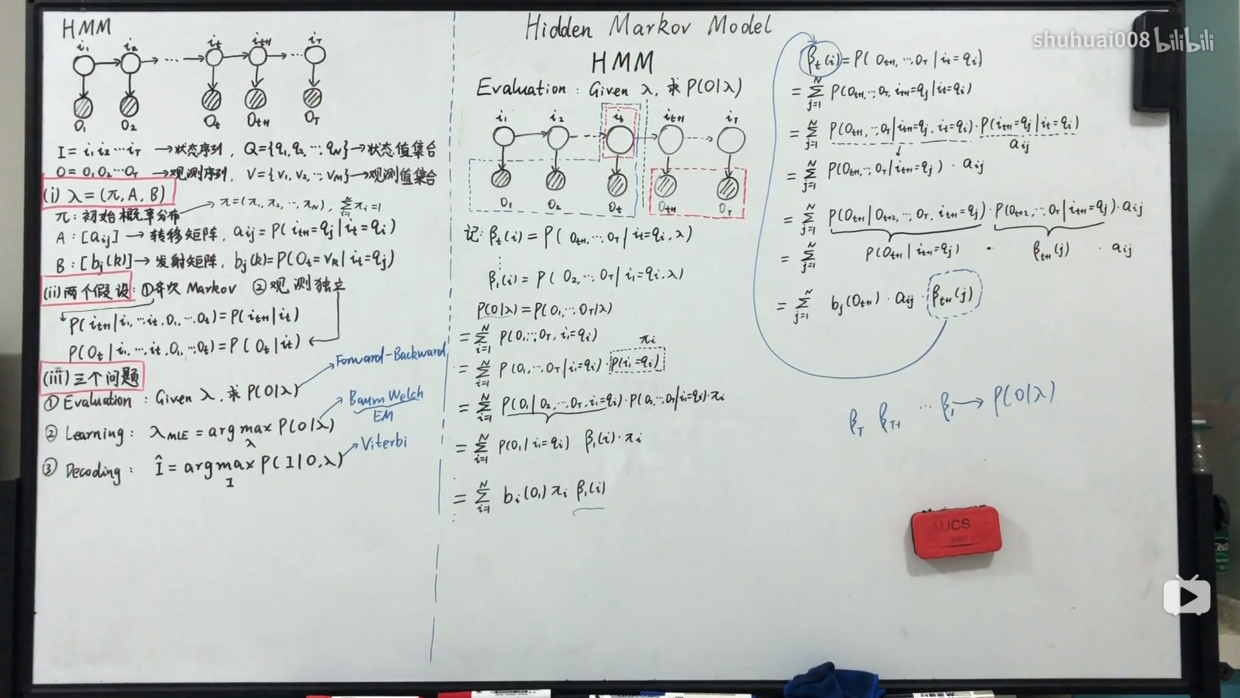

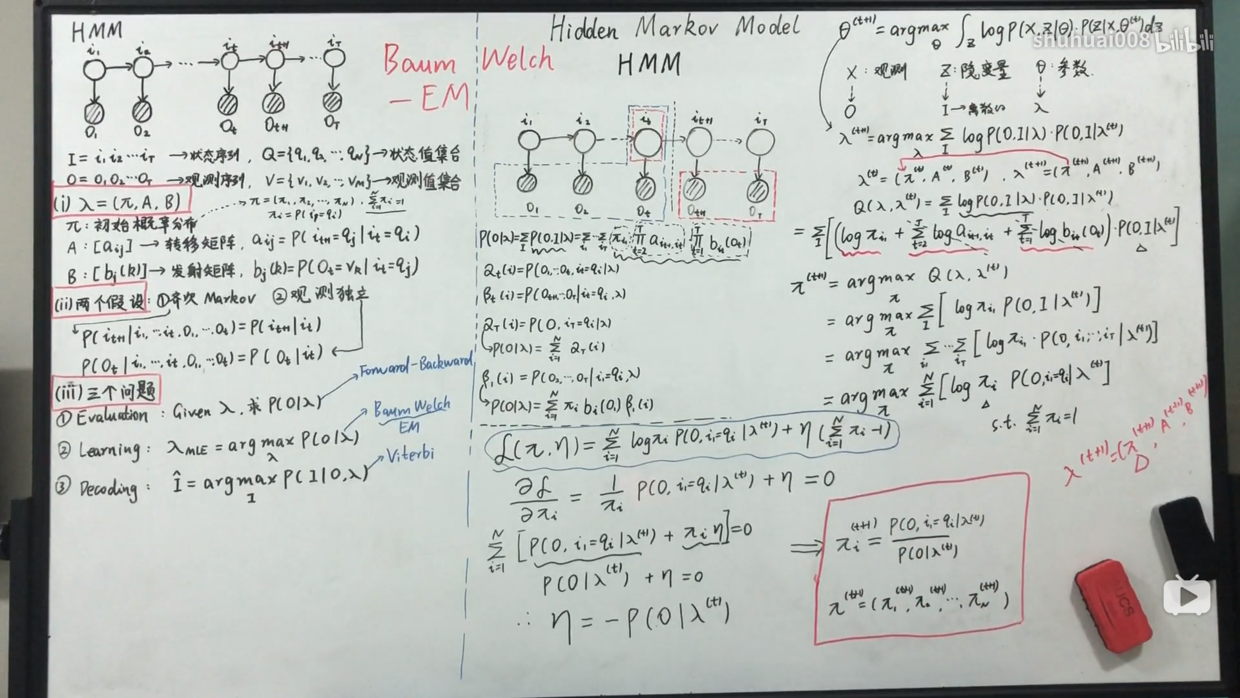

三个问题:

Evaluation:当已知各个参数,如何求得某个观测序列的概率。

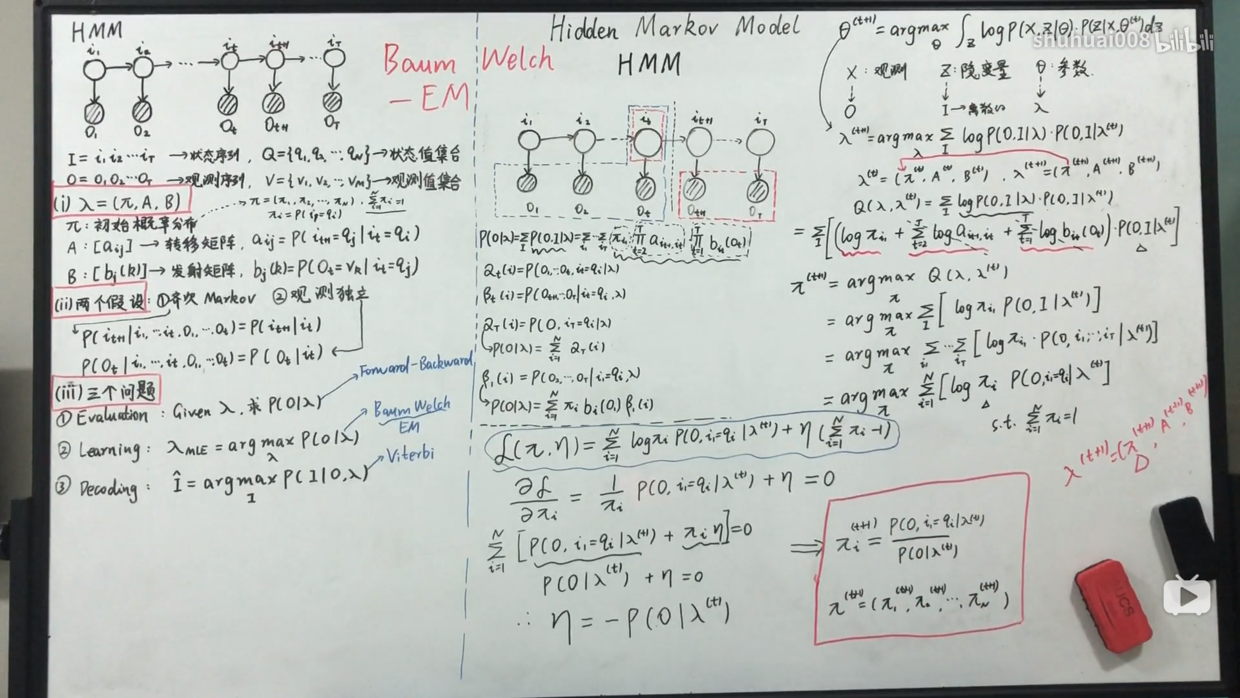

Learning:参数训练,EM算法(Baum-Welch)

Decoding:已知观测序列,求的参数使对应隐藏序列概率最大